Um telejornal customizado, apresentado por uma apresentadora virtual. Conheça a Aida e as tecnologias por trás dessa inovação na forma de divulgar notícias

Inovar é um requisito imprescindível para as organizações e tem feito parte dos planos estratégicos das empresas, não mais como alternativa de diferenciação, mas como uma necessidade para sua sobrevivência. Para inovar, produtos, processos ou até mesmo modelos de negócios precisam ser repensados. Por isso, é preciso atenção às tecnologias emergentes. Elas dão suporte a criação de novos produtos, despertando o interesse de pessoas pesquisadoras e empreendedoras devido ao grande potencial de rápido crescimento e impacto (muitas vezes ainda desconhecido) na sociedade. A Inteligência Artificial (IA) é uma dessas tecnologias emergentes. Ela é composta por algoritmos capazes de aprender e criar padrões a partir de dados, tornando o trabalho mais rápido e eficaz. Seu uso tem transformado diversas áreas, automatizando e trazendo benefícios para muitos processos.

Na produção de conteúdo não é diferente! A IA, associada aos avanços da computação gráfica, está ampliando as formas de geração de mídia sintética. O uso dessas tecnologias também é impulsionado pela necessidade de novos formatos de mídia. Diante dessas possibilidades tecnológicas e do crescente engajamento das pessoas para personagens virtuais, criamos o projeto Aida: um sistema que oferece a geração de mídia sintética como um serviço na nuvem, onde utilizamos IA e humanos virtuais realistas para apresentar resumos de notícias.

Mas, antes de explicar sobre o projeto Aida, é importante falarmos sobre mídia sintética e humanos virtuais.

O que é mídia sintética?

A descrição mais comum para mídia sintética é a criação ou alteração de mídias de maneira automatizada, utilizando IA. Tecnologias de geração de mídia sintética que usam deep learning são cada vez mais usadas comercialmente e são apontadas como o futuro da produção de conteúdo.

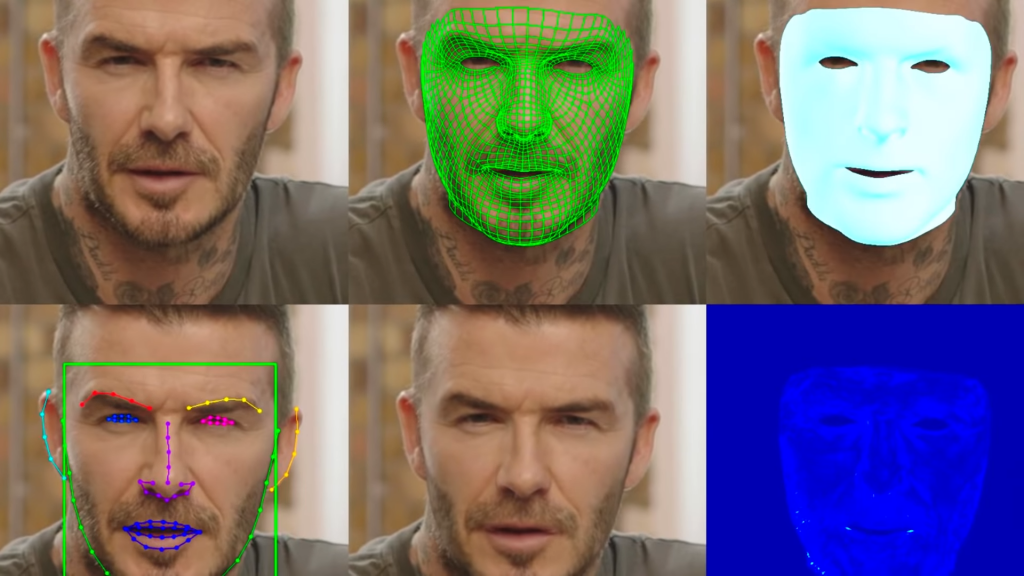

Existem vários tipos de mídias que podem ser geradas por IA: textos, áudios e vídeos. Hoje temos algoritmos capazes de responder perguntas e interpretar textos, como o GPT-3. Também existem algoritmos capazes de clonar vozes (sintetizando frases nunca ditas anteriormente pela pessoa) e modificar rostos em vídeos existentes (aplicando efeitos ou trocando rostos). Algumas pesquisas e usos dessa tecnologia devem revolucionar a indústria de entretenimento, viabilizando e acelerando processos de interpretação de dados, criação e produção de conteúdo audiovisual. Dentre os potenciais usos, podemos destacar: dublagem para outros idiomas, criação de âncoras virtuais, troca de rostos em dublês, rejuvenescimento, transferência de movimentos faciais para personagens 3D, entre outros. Um exemplo muito interessante de geração de mídia por IA foi a tecnologia de dublagem desenvolvida pela empresa Synthesia AI, que permitiu que David Beckham falasse nove idiomas para uma campanha contra a malária. Esse exemplo mostra o potencial que a geração de mídia sintética tem de quebrar barreiras linguísticas que existem para o conteúdo de vídeo atualmente, trazendo novos métodos de comunicação e desafiando nossa percepção do que é real e do que é sintético.

Figura 1: Tecnologia de dublagem usando IA fez com que David Beckham falasse 9 idiomas. Fonte: Panopticon.

O que são humanos virtuais?

Outro assunto da atualidade que precisamos abordar neste artigo é o tema “humanos virtuais”, que também podemos chamar de “seres virtuais”, já que não existem só humanas/os digitais, mas também animais, ETs e outros personagens fictícios, capazes de criar algum tipo de laço emocional com as pessoas. Eles podem ser baseados em pessoas reais ou podem ser criações originais. Seus usos podem variar desde substituição de dublês até pessoas influenciadoras, Vtubers (virtual youtubers), artistas musicais e assistentes virtuais.

Existem alguns benefícios que os humanos virtuais podem oferecer:

- Alta disponibilidade: seres virtuais estão disponíveis a qualquer horário, sem necessidade de definir uma jornada de trabalho;

- Segurança da marca: rostos e vozes que não são baseados diretamente em pessoas reais permitem que a empresa tenha controle total sobre a/o personagem, sem riscos de comprometer a segurança da imagem e durabilidade da/o personagem. Usar alguém real para basear o personagem cria riscos à imagem da marca caso essa pessoa se envolva em polêmicas. Não ter vínculo com alguém real também facilita a inserção de marcas e novos modelos de negócios.

- Nasce com um objetivo de negócio: a/o personagem é criado a partir das características e objetivos do negócio, seguindo o perfil da marca.

- Liberdade criativa: o personagem pode estar em qualquer época e lugar, com qualquer roupa. Ele não tem limitações de movimentos corporais e nem limitações de habilidades, podendo ser exibido realizando qualquer tarefa.

Alguns humanos virtuais fazem sucesso como influenciadores e estão atraindo um grande número de seguidores nas redes sociais. Um dos exemplos da atualidade é a Lil Miquela. A jovem californiana reúne mais de 3 milhões de seguidores no Instagram e trabalha como artista musical e modelo, promovendo marcas famosas de roupas e perfumes nas redes sociais.

Figura 2: A influenciadora virtual Miquela tem mais de 3 milhões de seguidores nas redes sociais. Fonte: Lil Miquela.

Aqui no Brasil, um grande exemplo é a Lu do Magalu, que tem se destacado como um rosto da marca Magazine Luiza e já possui mais de 5 milhões de seguidores. A empresa usa a personagem virtual por mais de uma década e mostra que o uso prolongado de um influenciador virtual pode ajudar a atrair fãs para a marca.

Além da Miquela e da Lu do Magalu, existem muitos outros humanos virtuais famosos. No site Virtual Humans você encontra uma grande lista de humanos virtuais, entrevistas e muitas notícias sobre o assunto.

Mas por que investir nisso?

Agora que os principais conceitos foram explicados, podemos focar nas perguntas: “Por que investir nisso?” e “Que benefícios essas duas áreas podem trazer?”.

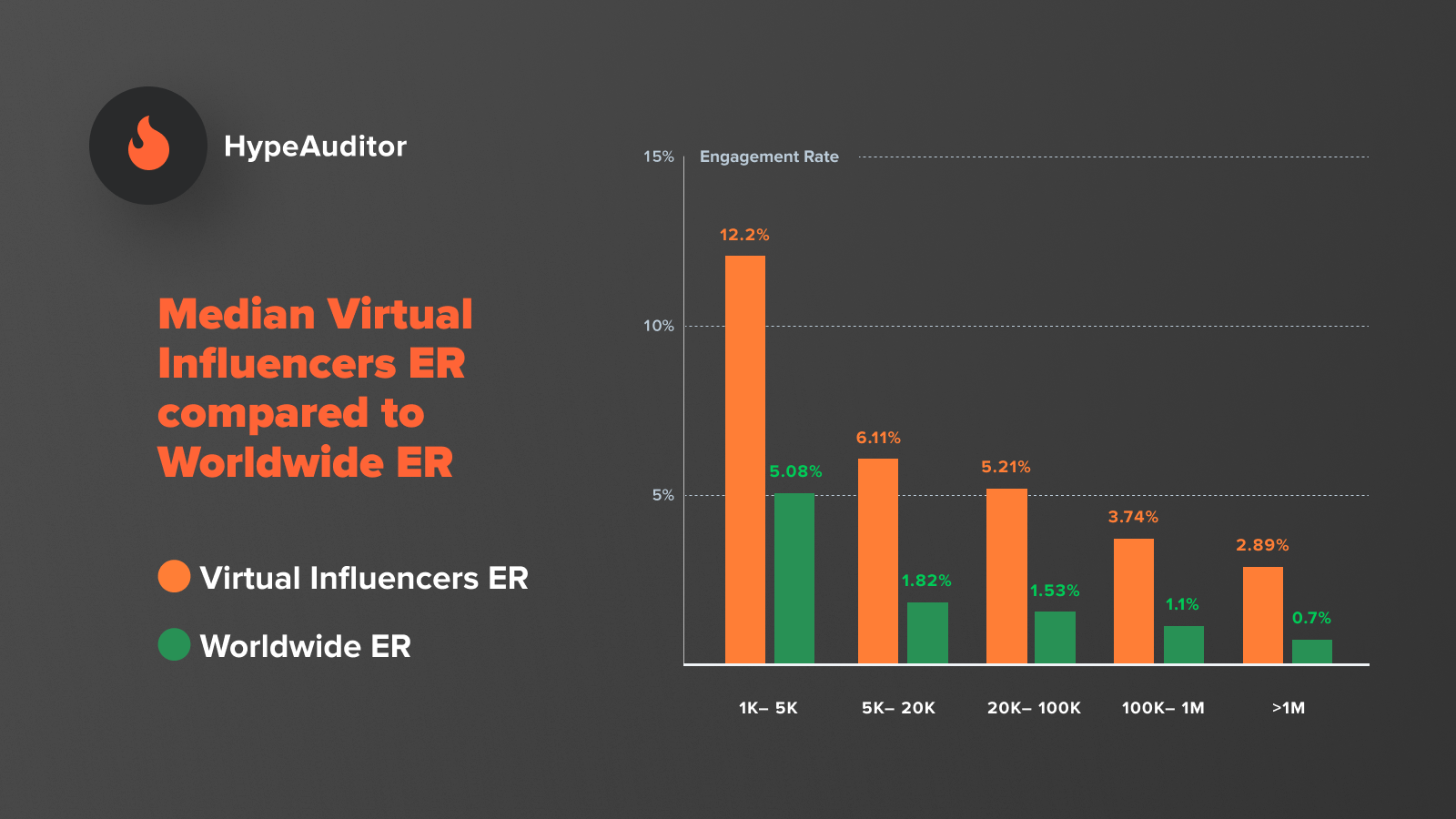

Pesquisas recentes no HypeAuditor apontam que a taxa de engajamento nas mídias sociais com influenciadores virtuais é quase três vezes maior do que a de um/a influenciador/a real tradicional. Isso reforça a ideia de que humanos virtuais podem ser ótimas oportunidades para as marcas divulgarem e promoverem seus produtos.

Figura 3: Pesquisas apontam que público tem maior engajamento por influenciadores virtuais, se comparado a influenciadores tradicionais. Fonte: HypeAuditor.

Se misturarmos as duas áreas, mídia sintética e humanos virtuais, encontraremos novas possibilidades, além das que já foram apresentadas aqui. E uma das possibilidades que se destacam é a criação de conteúdos personalizados, automatizados e em grande escala. Podemos dizer que é a união do cérebro com o coração.

Figura 4: Novas possibilidades de negócios com a junção das áreas de mídia sintética e humanos virtuais. Fonte: Globo Mediatech Lab.

Imagina você assistir um anúncio personalizado, com alguém que conhece seus gostos e fala diretamente com você? Ou então, que tal assistir um telejornal com as notícias de seu interesse? Pensando nessa última possibilidade, criamos o projeto Aida!

Aida

Unindo mídia sintética, humanos virtuais e outras tecnologias emergentes, desenvolvemos o sistema Aida, onde fizemos a automatização de ponta a ponta da produção de telejornais personalizados, com resumos de notícias atuais apresentados por uma âncora virtual (que também se chama Aida). Nosso sistema é baseado na nuvem, é eficiente em custos, escalável, customizável e pode gerar novas oportunidades de negócios.

Figura 5: Aida – sistema automático para criação de telejornal virtual. Fonte: Globo Mediatech Lab.

Um dos principais objetivos do projeto é a geração de conteúdos personalizados em grande escala. Para atingir esse objetivo, estamos usando várias tecnologias: geração de linguagem natural a partir de dados, sumarização automática de textos, text-to-speech, lip sync, captura de movimentos corporais e faciais, renderização de personagens realistas em tempo real e automatização de sistemas na nuvem.

O que são essas tecnologias?

Geração de linguagem natural: são sistemas capazes de produzir textos compreensíveis em línguas humanas. Nos últimos anos, os avanços da IA permitiram que esses sistemas fossem usados para resumo de dados financeiros e de negócios. Outro uso crescente é na área de jornalismo automatizado. Esses sistemas aceleram o processo de entrega das notícias, permitindo, por exemplo, que os jornalistas se concentrem em tarefas mais complexas enquanto o computador interpreta os dados e gera textos em um trabalho mais mecânico, como mostra esse estudo da Universidade de Helsinki.

Sumarização automática de textos: similar ao que um humano faria ao resumir um texto, a sumarização automática de textos tem o objetivo de identificar segmentos relevantes de um texto e compô-los para gerar sumários (que são os textos resumidos). O resumo gerado deve ter um enredo claro e progressivo, desenvolvido em torno de uma ideia central, que deve combinar com a ideia central da fonte. Um dos principais desafios da sumarização automática é simular a reescrita de um texto, pois exige capacidade de interpretação e representação de parte do texto. Os métodos mais comuns são: métodos estatísticos; métodos baseados em modelagem discursiva; e métodos que utilizam técnicas de aprendizado de máquina.

Text-to-speech: é o processo de produção artificial de fala humana a partir de textos. Com os avanços das tecnologias de aprendizado de máquina para conversão de textos em vozes, foi possível a criação de ferramentas que geram falas cada vez mais naturais. Essa tecnologia tem sido usada por diversas empresas para melhorar as interações das pessoas clientes com interfaces de usuários, que podem personalizar a comunicação de acordo com suas preferências por voz e idioma. No entretenimento, jogos e outras produções usam a tecnologia para gerar narrações. A síntese de voz também tem se mostrado uma grande aliada da tecnologia assistida, ajudando diversas pessoas com deficiências.

Lip sync: é um termo técnico para dublagem, onde os movimentos labiais são sincronizados (combinados) com uma fala. Essa técnica é muito comum no mundo do entretenimento, em animações ou musicais, onde a dublagem é feita por pessoas. Mas, nos últimos anos, o lip sync também tem sido usado em jogos ou manipulação de vídeos. A tecnologia de lip sync usa redes neurais para combinar um segmento de fala com as expressões labiais do personagem ou da pessoa em um vídeo. Ela é capaz de analisar o áudio, identificar os fonemas e ativar as animações faciais correspondentes, fazendo o sincronismo labial.

Captura de movimentos corporais e faciais: (motion capture ou mocap, em inglês) é a transferência de movimentos de um ator real para um personagem virtual. Para a captura corporal, o ator veste uma roupa especial com marcadores posicionados nas “articulações” do corpo (regiões de rotação corporal) e através de softwares é possível localizar esses marcadores, interpretar os movimentos e transferir para o personagem. Existem várias formas de capturar movimentos corporais, mas os sistemas mais utilizados são baseados nas tecnologias óptica, magnética e inercial. A captura facial permite a detecção e rastreio de pontos de interesse da face (como expressões faciais e pose da cabeça) por meio de marcadores posicionados no rosto do ator real ou técnicas de aprendizagem de máquina, como redes neurais.

Renderização de humanos virtuais realistas: atualmente é possível criar humanos digitais realistas, graças aos avanços de hardwares e softwares gráficos. Existem basicamente duas formas de gerar humanos virtuais: através da manipulação de vídeos (com técnicas de geração de mídia sintética usando IA) ou renderizando modelos de personagens 3D. Usando a primeira abordagem, algumas empresas desenvolveram âncoras virtuais realistas, cujas expressões corporais e movimentos faciais são inferidos previamente por modelos treinados com muitas horas de vídeos de apresentadores reais. A segunda forma de criação de humanos virtuais não depende mais de métodos de renderização offline demorados, que levavam muitas horas para a geração de alguns frames. Agora podemos contar com o poder de game engines atuais, como a Unity e Unreal, que são capazes de renderizar seres humanos digitais fotorrealistas em tempo real. A renderização em games engines oferece algumas vantagens: troca rápida e fácil de características do personagem e cenários (como troca de roupas, cabelo, acessórios etc.); pontos de vistas diferentes da cena (é possível fazer passeios e troca de câmeras virtuais); e rápida entrega de conteúdo (já que a cena é renderizada em tempo real).

Software as a Service (SaaS): como o nome sugere, o sistema é comercializado como um serviço e não como um produto. As aplicações são usadas pela internet, dispensando instalações de programas nos equipamentos. Uma das vantagens que essa tecnologia traz é o fato de o software poder ser usado em qualquer lugar, em qualquer dispositivo e a qualquer momento. A única exigência é ter acesso à internet. Além do acesso remoto, os sistemas hospedados na nuvem trazem outros benefícios: redução de custos; facilidade de atualizações e melhorias; e dispensa investimentos e manutenção de infraestrutura complexa.

Como você pôde ver, muitas dessas tecnologias emergentes já estão com a IA incorporada em seus processos, reforçando a ideia de que a IA veio para ficar.

Mas e o projeto Aida? Como essas tecnologias foram usadas no projeto?

Decidimos juntar todas essas tecnologias em um sistema onde a pessoa usuária, de maneira simples, pode criar um telejornal virtual automaticamente com um resumo das principais notícias da semana.

Processos Artísticos

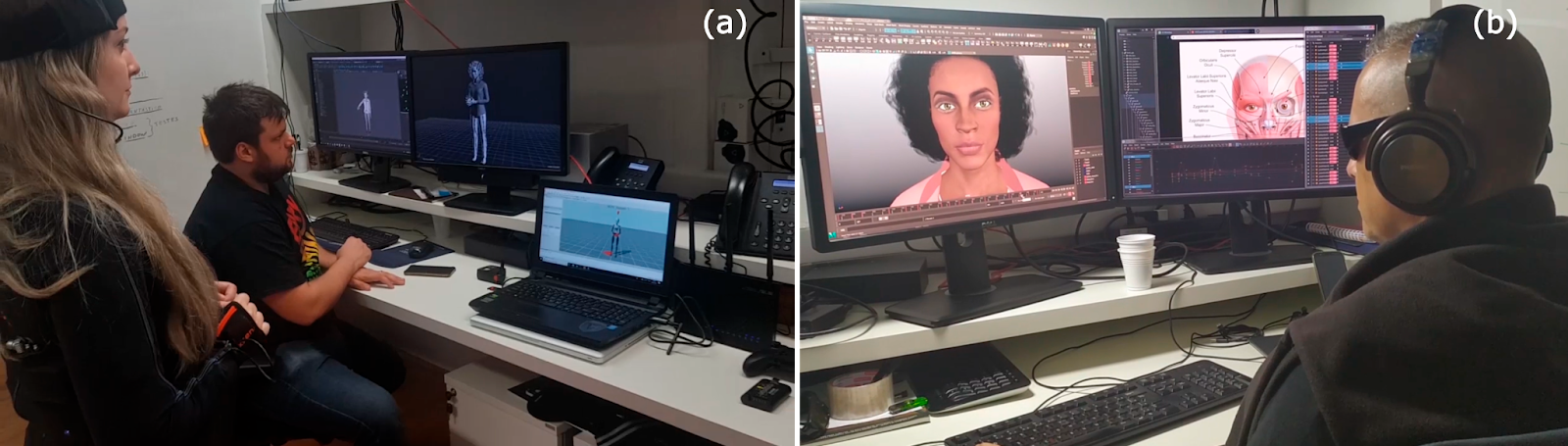

Para dar vida à nossa âncora virtual, modelamos uma personagem realista que não existe no mundo real. Adotamos um pipeline de desenvolvimento de jogos, pois um dos requisitos do sistema era que a renderização da cena fosse em tempo real, possibilitando a entrega mais rápida do conteúdo para a pessoa usuária.

Usando as técnicas de shaders para humanos virtuais adotadas em jogos e projetos em tempo real atuais, é possível modelar e renderizar personagens mais realistas. A Figura 6 mostra o resultado do modelo 3D da nossa âncora virtual renderizada em tempo real.

Figura 6: Modelo 3D da âncora virtual Aida. Fonte: Globo Mediatech Lab.

Além do modelo 3D realista, a nossa âncora virtual também precisava de movimentos corporais e faciais naturais. Para isso usamos uma tecnologia de captura de movimentos baseada em sensores inerciais (que pode ser usada em qualquer lugar, dentro ou fora do estúdio), fizemos algumas correções e transferimos esses movimentos para a nossa personagem. Os movimentos faciais são resultantes de estudos anatômicos e cinesiológicos, gerando expressões faciais e animações de visemas (expressões labiais que correspondem a um determinado segmento de fala) mais realistas durante a fala.

Figura 7: Para dar mais naturalidade para o comportamento da Aida (a) fizemos a captura de movimentos corporais de uma pessoa real e (b) fizemos as expressões faciais baseadas em estudos anatômicos. Fonte: Globo Mediatech Lab.

Funcionamento do sistema

A seguir, vou explicar o funcionamento do sistema Aida por partes.

Figura 8: Etapas do funcionamento do sistema Aida. Fonte: Globo Mediatech Lab.

Etapa 1 – Acesso do sistema pela pessoa usuária: Inicialmente, a pessoa usuária acessa a interface do sistema a partir de uma página da web usando um dispositivo (celular, tablet ou computador). Ela seleciona as notícias que gostaria de ouvir a partir de uma lista com as últimas notícias publicadas em diversos sites. Elas são fornecidas pela API do Bing News e são filtradas conforme os nichos de interesse da pessoa usuária – esportes, política, tecnologia, economia, saúde etc. Como existem uma infinidade de artigos, implementamos um algoritmo de classificação para selecionar os textos que melhor se encaixam em um noticiário. O nosso algoritmo de classificação inicialmente mede a legibilidade de um texto com base em sua estrutura, depois identifica se o texto possui muitas citações (evitamos citações para que a fala da Aida não seja confundida com a fala de outras pessoas), verifica se o texto é longo (textos longos aumentam a probabilidade de extrair trechos que não representam o artigo como um todo) e verifica se o texto está em primeira pessoa (como regra editorial, não queremos que a Aida reproduz artigos de opinião).

Nesta primeira etapa do sistema também é possível escolher o estilo (ou tom) de apresentação. Temos dois tons disponíveis: o tom formal, inspirado em telejornais tradicionais, onde nossa âncora virtual apresenta as notícias sentada em uma bancada enquanto o painel atrás dela exibe ilustrações e vídeos relevantes do assunto; e o tom informal, com mudanças no cenário (as imagens e vídeos são exibidos em uma tela flutuante ao lado dela) e no estilo da nossa âncora, com roupas mais informais e comportamento mais despojado. É importante ressaltar que o conteúdo da reportagem é o mesmo para ambos os tons de apresentação, o que muda é a forma de como o conteúdo é apresentado. O principal objetivo de disponibilizarmos dois modos de apresentação é atingir públicos com gostos diferentes, tornando a pessoa usuária mais confortável e engajada.

Figura 9: Tons de apresentação: (a) formal e (b) informal. Fonte: Globo Mediatech Lab.

Etapa 2 – Resumo e geração de textos em linguagem natural: assim que a pessoa usuária escolhe as manchetes de seu interesse, a página envia suas preferências e configurações para o módulo aida-api que também está na nuvem. Esta API é um servidor que gerencia todos os serviços e interage com a página da web. Com os artigos selecionados em “mãos” o nosso sistema pode fazer a sumarização dos textos. Usamos uma técnica de sumarização extrativa, chamada LSA, que classifica cada sentença em relação a sua contribuição geral para o documento. Com isso é possível criarmos um resumo com quantas frases desejarmos. Nesse projeto, limitamos cada resumo em até 60 palavras.

Na etapa 2 também geramos textos em linguagem natural a partir de dados de previsão de tempo (extraídos do Dark Sky). Implementamos uma tecnologia própria baseada em NLG simples. O texto gerado sobre a previsão do tempo é apresentado no final, logo após a narração das notícias.

Etapa 3 – Conversão de textos em falas: usamos serviços de text-to-speech (TTS), como o da Microsoft, para sintetizar a voz da Aida narrando os textos. Esses serviços são baseados em deep learning e apresentam vozes realistas. Depois de produzir os áudios, eles são disponibilizados para a próxima etapa em um bucket (espécie de cache para tornar o acesso mais rápido).

Etapa 4 – Lipsync: a sincronização labial usada neste sistema é uma adaptação da ferramenta fornecida pela Oculus, que através de redes neurais realiza a sincronização entre os áudios e visemas. Esse processo permite que a Aida duble os áudios gerados anteriormente. O processo de lip sync é feito em tempo real, junto com a etapa de renderização.

Etapa 5 – Renderização do telejornal virtual: é na etapa de renderização que reunimos tudo o que foi produzido, aplicamos as preferências da pessoa usuária em relação ao estilo de apresentação e processamos a cena virtual em tempo real. Como já foi mencionado, uma das vantagens de usar game engines é a flexibilidade de personalização da/o personagem e cenário (podemos mudar em tempo de execução características como cabelo, roupas, cenários e câmeras virtuais).

Desenvolvemos a aplicação que cuida da renderização da parte gráfica e da sincronização labial na Unreal. Para executar essa aplicação usamos instâncias equipadas com unidades de processamento gráfico (GPUs). O servidor aida-api envia as preferências das pessoas usuárias e os áudios gerados para a instância que contém a aplicação de render em tempo real.

Etapa 6 – Streaming ou geração de vídeo: é a última etapa do sistema, quando podemos fazer um streaming em tempo real do que está sendo renderizado (transmitindo para canais tradicionais e para a web), ou gerar um arquivo de vídeo, gravando a renderização e disponibilizando o vídeo para a pessoa usuária (Video On Demand – VOD).

Neste vídeo você pode ver o nosso sistema Aida em execução, com a nossa âncora virtual apresentando algumas notícias (nesse exemplo é em inglês, mas ela fala em português também), cenas de making-off e alguns eventos que participamos com esse projeto.

Vantagens

As principais vantagens desse sistema são:

- Customização do conteúdo: personagem e cenário podem ser modificados, conforme as preferências das pessoas usuárias.

- Velocidade de produção de conteúdo: quando a instância da máquina de renderização já está iniciada, todo o processo do nosso sistema (da etapa 1 a etapa 6) é feito em cerca de 10 segundos.

- Proteção da marca: no caso da Aida, o modelo da personagem e a voz não estão relacionados diretamente a uma pessoa real. Isso traz segurança para a marca e controle total da imagem do personagem.

- Escalabilidade: conseguimos atingir pessoas usuárias diferentes simultaneamente, graças às diversas instâncias que podemos criar na nuvem, onde cada instância potencialmente gera um vídeo específico para um usuário.

- Baixos custos de produção: para uma demanda de 10 mil vídeos mensais, com duração de 3 min cada um, teríamos o custo mensal aproximado de 7 centavos de dólar para cada vídeo.

Futuros casos de uso

O sistema Aida pode ser adaptado para outros personagens e para outros modelos de negócios, criando conteúdo para publicidade, jornalismo e entretenimento. Podemos usar metadados das pessoas usuárias para saber suas preferências e sermos mais assertivos quando oferecermos um conteúdo.

Para a publicidade, a personalização do conteúdo é muito relevante, pois possibilita a geração de anúncios personalizados para grupos de usuários ou indivíduos. A facilidade de customização do personagem e cenário virtual permite a inserção de produtos na cena virtual. A/O personagem também pode usar roupas e acessórios divulgando marcas.

Para o entretenimento, podemos pensar em usar o sistema para a criação de um/a comentarista virtual ao vivo de e-sports, que pudesse fazer análises em tempo real dos jogos. Outro caminho interessante é a criação de influenciadores virtuais, que podem engajar o público para assuntos específicos.

Provavelmente existem mais usos que iremos descobrir com o tempo e evolução das tecnologias.

Autora Priscila Ariel, Pesquisadora de Inovação na Globo Doutoranda em Computação Gráfica na PUC-Rio. Fez Mestrado e Bacharelado em Ciência da Computação na UERJ. Tem experiência nas áreas de computação gráfica, visão computacional, realidade virtual, realidade aumentada e inteligência artificial. Atualmente coloca em prática todos esses conhecimentos no laboratório de inovação da Globo, o Mediatech Lab. https://www.linkedin.com/in/priscila-ariel-22a44592/ Revisora Luciana Fleury, jornalista

Este conteúdo faz parte da PrograMaria Sprint Cases de Inovação e Tecnologia da Globo.

O que você achou deste conteúdo? Responda nosso feedback:

Eu estou perplexa com esse texto. Pude aprender sobre diversos conceitos que eu não conhecia e entender o engajamento da equipe da Globo para fazer parte do futuro da tecnologia. Muito obrigada por esse aprendizado!

Realmente interessante a forma como a inserção de IA no mercado pode modificar as formas de consumo e principalmente auxiliar o engajamento pessoal. Principalmente em relação à pessoas que possuem algum tipo de dificuldade. Parabéns pelo artigo, muito claro e exemplar.